Meta' s Gedachtenlezer

Stel je voor dat je kunt zien wat iemand anders ziet of denkt, alleen door naar zijn of haar hersenactiviteit te kijken. Dat klinkt misschien als sciencefiction, maar het is precies wat een team van onderzoekers van Meta, het moederbedrijf van Facebook, Instagram, WhatsApp en Oculus VR, heeft gedaan.

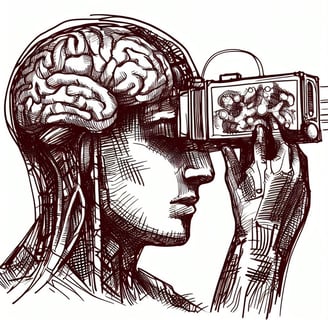

In een nieuw onderzoek dat vorige week is gepubliceerd, presenteren de onderzoekers een AI-systeem dat in staat is om visuele voorstellingen in de hersenen te decoderen met behulp van magneto-encefalografie (MEG), een niet-invasieve beeldvormingstechniek die duizenden metingen van de hersenactiviteit per seconde maakt. Het AI-systeem kan in realtime reconstrueren hoe beelden worden waargenomen en verwerkt door de hersenen.

Het AI-systeem bestaat uit drie delen: een beeldencoder, een hersencoder en een beelddecoder. De beeldencoder bouwt een rijke verzameling van representaties van het beeld onafhankelijk van de hersenen. De hersencoder leert vervolgens om MEG-signalen af te stemmen op deze beeldinbeddingen. Ten slotte genereert de beelddecoder een plausibel beeld op basis van deze hersenrepresentaties.

De onderzoekers trainden dit systeem op een openbare dataset van MEG-opnames die zijn verkregen van gezonde vrijwilligers en die zijn vrijgegeven door Things, een internationaal consortium van academische onderzoekers die experimentele gegevens delen op basis van dezelfde beelddatabase. Ze vergeleken de decoderingsprestaties die werden verkregen met verschillende vooraf getrainde beeldmodules en toonden aan dat de hersensignalen het best overeenkomen met moderne computer vision AI-systemen zoals DINOv2, een recent zelf-supervised architectuur die in staat is om rijke visuele representaties te leren zonder menselijke annotaties.

Dit resultaat bevestigt dat zelf-supervised leren AI-systemen ertoe brengt om hersenachtige representaties te leren: de kunstmatige neuronen in het algoritme worden op een vergelijkbare manier geactiveerd als de fysieke neuronen in de hersenen in reactie op hetzelfde beeld.

De beelden die de vrijwilligers zien (links) en die worden gedecodeerd uit MEG-activiteit op elk moment (rechts). Elk beeld wordt ongeveer elke 1,5 seconde gepresenteerd.

Dit onderzoek versterkt Meta’s langetermijnonderzoeksinitiatief om de grondslagen van menselijke intelligentie te begrijpen, de overeenkomsten en verschillen met huidige machine learning algoritmen te identificeren, en uiteindelijk te helpen bij het bouwen van AI-systemen met het potentieel om te leren en redeneren als mensen.

Op de lange termijn kan dit ook een opstapje zijn naar niet-invasieve hersen-computerinterfaces in een klinische setting die mensen kunnen helpen die, na het lijden aan een hersenletsel, hun vermogen om te spreken hebben verloren